文心一言发布在即寒武纪思元590将迎首秀百度:一定程度可替代A100

《科创板日报》3月15日讯(记者 郭辉) 科技产业的“大哉问”——从去年的“我们距离英伟达有多远”到今年“我们距离ChatGPT又有多远”,一直缺乏极具事实性的有力回答。而随着百度即将于明日(16日)推出文心一言,百度方面关于国产最先进AI算力芯片思元590的使用体验也一并曝光,或为市场判断进一步提供依据。

日前网络流传的一份百度集团交流纪要显示,“文心一言”将调用超大规模算力,并且尝试使用寒武纪思元590替代英伟达A100。

截至发稿,百度方面并未就纪要内容置评。但据《科创板日报》记者与百度一位业务人士的交流了解,该项布局属实。寒武纪方面称思元590未正式发布,产品在百度相关项目中的应用需向公司业务部门了解,不过截至记者发稿,并未获得进一步回应。

纪要内容显示,疑为百度相关业务负责人回答称,同时选用英伟达与寒武纪等公司产品,是不愿被某一家供应商卡脖子。同时百度也希望进行一些备货,“除了英伟达A100和寒武纪思元590,其他性能差一点的替代品也考虑”。

对于供应商选择,该人士称在已经量产的情况下,会考虑到供应商自身业务体量和软件编程生态,并且在问答中详细比较了不同的国内厂商及其产品。

云端推理芯片方面,“从性能表现上,以算力功耗密度为比较的参数,第一梯队是阿里,第二梯队是百度、寒武纪、遂愿,第三梯队是依图。从量产的成熟度考虑,已经量产并且已经对外独立商业输出的就是阿里、百度、寒武纪。”不过百度没有选用阿里AI芯片,据称是由于市场反馈后者牺牲了通用性,导致使用场景相对较窄。

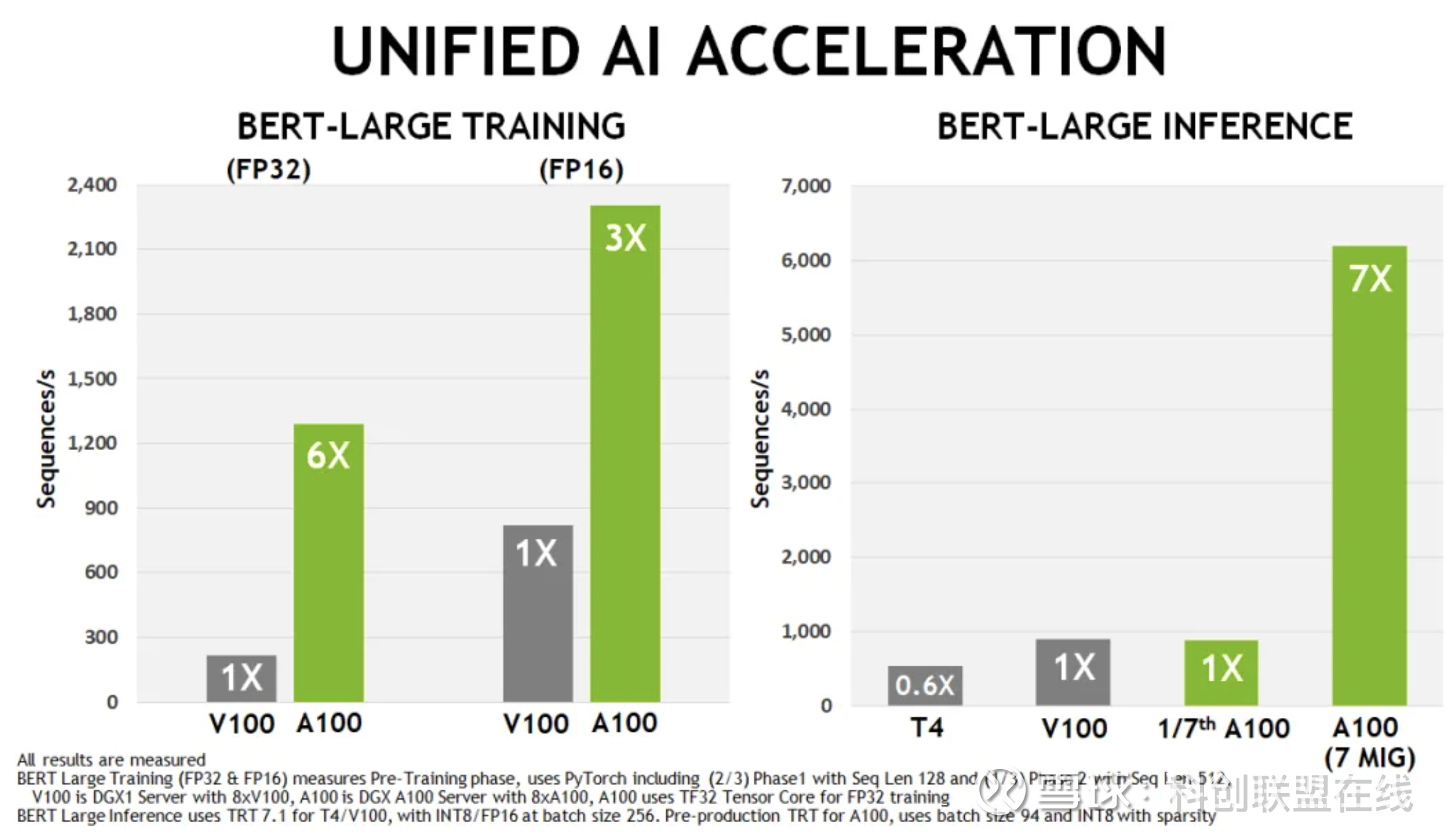

其中,百度方面以英伟达T4为标尺,认为百度、寒武纪、遂愿的云端推理芯片达到了英伟达T4性能水平。据了解,英伟达A100 GPU 在BERT训练和推理上的性能分别较前代v100提升了6倍跟7倍,但英伟达t4推理能力只有v100的60%。

思元590是寒武纪最新一代云端智能训练芯片,该产品目前尚未正式发布。但在2022年世界人工智能大会上,寒武纪董事长陈天石在演讲中透露了该产品信息。

据介绍,思元590采用MLUarch05全新架构,实测训练性能较在售旗舰产品有大幅提升,能够提供更大的内存容量和更高的内存带宽,其IO和片间互联接口也较上代实现大幅升级。

如今看来,百度成为寒武纪思元590的首批尝鲜者,并且曝光产品首份“开箱”体验。纪要显示,百度人士认为思元590能够在一定程度上代替A100,但在软件适配度、稳定性方面仍显不足。

“当时还没有出思元590的时候,我们认为(华为)昇腾910是国内唯一可以接近A100的卡。”但从思元590目前在内部导入测试一些模型任务的完成进度来看,“优于昇腾910”。纪要显示百度相关人士表示,尽管思元590和A100不好直接去点对点的对比,但在整体性能上——至少在AIGC这种业务对于算力的需求上,“可以一定程度上代替A100”。

“寒武纪基础软件平台的研发实力和相应的解决方案能力,是有大幅度提升的。在推理的加速引擎方面,从百度的视角来看,寒武纪所谓的MagicMind这套东西,可能觉得还是班门弄斧了,和百度相对比较健全的软件架构以及稳定性还有差距。”

寒武纪芯片究竟能否代替英伟达A100的问题,当事人怎么看?

在今年的一场AI行业公开论坛中,寒武纪联合创始人、执行总裁王在曾表示,公司创新性架构已经在手机等硬件设备上得到了应用和验证,尤其是在2016年前后,寒武纪产品较英伟达更加高效。

但随着寒武纪有针对性地推出云端芯片,英伟达还是在过去几年中近乎独占了AI训练、推理市场。王在称,原因一方面是用户的使用习惯和迁移成本,另一方面还有易用性的问题。

“基于我们本身架构的稳健性,其实我们潜力是有的。这几年寒武纪积累最多的,还是软件方面客户给予的反馈。”王在表示:“我个人认为,现阶段寒武纪相关产品已经可以达到包括A100等产品的水平。”

市场调查机构TrendForce此前公布的报告指出,如果以英伟达A100显卡的处理能力计算,运行ChatGPT将需要使用到3万块英伟达GPU。有消息显示,刚刚发布的GPT-4将会达到100万亿参数,较ChatGPT所基于的GPT-3.5有着600倍的提升,对高性能算力芯片的需求将进一步提升。

百度方面则为支持文心一言的超大规模计算需求,已于今年3月完成百度阳泉智算中心升级。

鲸平台智库专家、方融科技高级工程师周迪表示,通过降低成本、服务器响应时间,一定程度上能够换取算力芯片可控性。“由于GPU并行算力的特点,当算力不足的时候可以通过堆叠GPU数量的方式来提高算力。不过积极进行GPU堆叠并行的研究,寻求替代产品才是解决之道。”